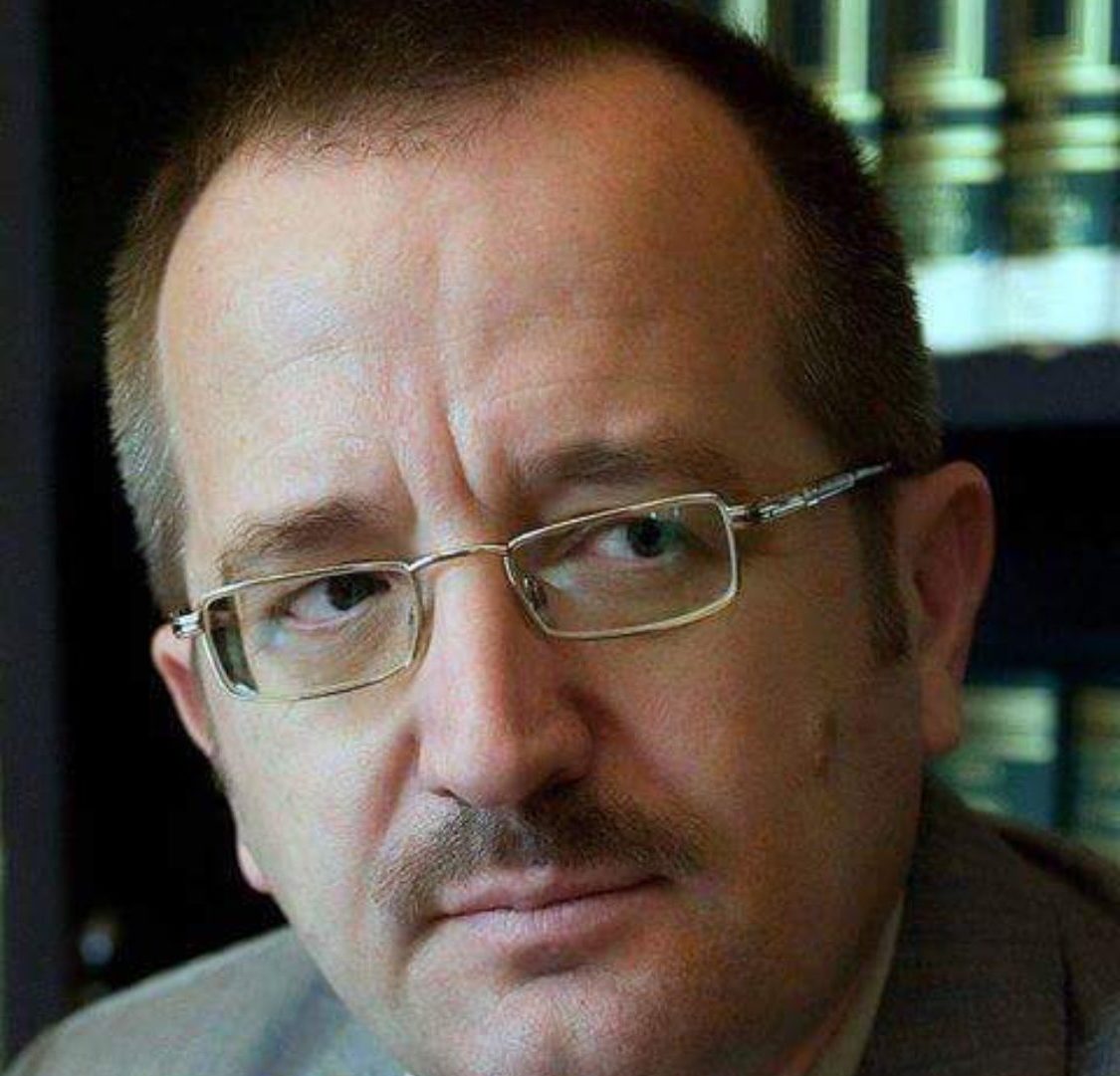

Daniel Kokotajlo, një ish-kërkues në divizionin e drejtimi të OpenAI

Një grup punonjësish dhe ish-punonjësish po bëjnë thirrje për ndryshime gjithëpërfshirëse në industrinë e inteligjencës artificiale, duke përfshirë transparencë më të madhe dhe mbrojtje për sinjalizuesit

Daniel Kokotajlo, një ish-kërkues në divizionin e drejtimit të OpenAI, është një organizator i një grupi ish-punonjësish dhe punonjësish, të cilët thonë se kompania ka një kulturë të pamatur.

Një grup personash të brendshëm të OpenAI-së po sinjalizonin mbi atë që ata thonë se është një kulturë e pamaturisë dhe fshehtësisë në kompaninë e inteligjencës artificiale me bazë në San Francisko, e cila po garon për të ndërtuar sistemin AI më të fuqishëm ndonjëherë.

Grupi, i cili përfshin nëntë punonjës dhe ish-punonjës të OpenAI, ka dalë hapur ditët e fundit rreth shqetësimeve të përbashkëta se kompania nuk ka bërë mjaftueshëm për të parandaluar sistemin e saj AI që të mos bëhet e rrezikshme.

Anëtarët thonë se OpenAI, që filloi si një laborator kërkimor jofitimprurës dhe shpërtheu në opinionin publik me lëshimin e ChatGPT në 2022, po i jep përparësi fitimeve dhe rritjes ndërsa përpiqet të ndërtojë inteligjencën e përgjithshme artificiale, ose A.G.I., termi i industrisë për një program kompjuterik, i aftë për të bërë gjithçka mundet një njeri.

Ata gjithashtu pretendojnë se OpenAI ka përdorur taktika të forta për të parandaluar punëtorët që të shprehin shqetësimet e tyre për teknologjinë, duke përfshirë marrëveshjet kufizuese që punonjësve në largim iu kërkua të nënshkruanin.

“OpenAI është me të vërtetë i emocionuar për ndërtimin e A.G.I., dhe ata po garojnë në mënyrë të pamatur për të qenë të parët atje”, tha Daniel Kokotajlo, një ish-kërkues në divizionin e drejtimit të OpenAI dhe një nga organizatorët e grupit.

Grupi publikoi një letër të hapur të martën duke bërë thirrje për udhëheqjen e kompanive AI kompanitë, duke përfshirë OpenAI, për të vendosur transparencë më të madhe dhe më shumë mbrojtje për sinjalizuesit.

Anëtarë të tjerë përfshijnë William Saunders, një inxhinier kërkimi që u largua nga OpenAI në shkurt, dhe tre ish-punonjës të tjerë të OpenAI: Carroll Wainwright, Jacob Hilton dhe Daniel Ziegler. Disa punonjës të OpenAI e miratuan letrën në mënyrë anonime sepse kishin frikë nga hakmarrja nga kompania, tha Kokotajlo. Një punonjës i tanishëm dhe një ish-punonjës i Google DeepMind, AI qendrore e Google, gjithashtu ka nënshkruar.

Një zëdhënëse për OpenAI, Lindsey Held, tha në një deklaratë: “Ne jemi krenarë për të kaluarën tonë duke ofruar AI më të aftë dhe më të sigurt dhe besoni në qasjen tonë shkencore për adresimin e rrezikut. Ne pajtohemi se debati rigoroz është vendimtar duke pasur parasysh rëndësinë e kësaj teknologjie dhe ne do vijojmë të angazhohemi me qeveritë, shoqërinë civile dhe komunitetet e tjera në mbarë botën.”

Një zëdhënës i Google nuk pranoi të komentojë.

Fushata vjen në një kohë të vështirë për OpenAI. Ajo është ende duke u rikuperuar nga një përpjekje për “grusht shteti” vitin e kaluar, kur anëtarët e bordit të kompanisë votuan për të shkarkuar Sam Altman, shefin ekzekutiv, për shqetësimet rreth sinqeritetit të tij. Altman u kthye disa ditë më vonë dhe bordi u riformua me anëtarë të rinj.

Kompania gjithashtu përballet me beteja ligjore me krijuesit e përmbajtjes, të cilët e kanë akuzuar atë për vjedhje të veprave të mbrojtura nga të drejtat e autorit për të stërvitur modelet e saj.

New York Times paditi OpenAI-n dhe partnerin e saj, Microsoft-in, për shkelje të të drejtave të autorit vitin e kaluar. Zbulimi i fundit i një asistenti zëri gati të vërtetë dëmtua nga një grindje publike me aktoren e Hollivudit Scarlett Johansson, e cila pretendoi se OpenAI kishte imituar zëri i saj pa leje.

Por asgjë nuk ka ngecur si akuza se OpenAI ka qenë shumë e ashpër përsa i përket sigurisë.

Muajin e kaluar, dy punonjës prek shumë kohësh në AI, studiuesit Ilya Sutskever dhe Jan Leike, u larguan nga OpenAI. Dr. Sutskever, i cili kishte qenë në bordin e OpenAI dhe votoi për shkarkimin e Altman, kishte ngritur alarmin për rreziqet e mundshme të sistemeve të fuqishme të AI. Largimi i tij u pa nga disa punonjës si një pengesë.

Kështu ishte edhe largimi i Dr. Leike, i cili së bashku me Dr. Sutskever kishin udhëhequr ekipin e “superlinjimit” të OpenAI, i cili u përqendrua në menaxhimin e rreziqeve të modeleve të fqishme të AI. Në një seri postimesh publike që njoftonin largimin e tij, Dr. Leike tha se ai besonte se “kultura dhe proceset e sigurisë kanë zënë vendin e dytë në kompani”.

As Dr. Sutskever dhe as Dr. Leike nuk e nënshkruan letrën e hapur të shkruar nga ish-punonjësit. Por largimet e tyre nxitën ish-punonjësit e tjerë të OpenAI të flasin hapur.

“Kur u regjistrova për OpenAI, nuk u regjistrova për këtë qëndrim “Le t’i nxjerrim fillimisht gjërat në rrjete për botëb dhe të shohim se çfarë ndodh dhe t’i rregullojmë ato më pas”, tha Saunders.

Disa nga ish-punonjësit kanë lidhje me altruizmin efektiv, një lëvizje e frymëzuar nga utilitarizmi mbi shqetësimin vitet e fundit me parandalimin e kërcënimeve ekzistenciale nga AI. Kritikët kanë akuzuar lëvizjen për promovimin e skenarëve të fundit të botës në lidhje me teknologjinë, siç është nocioni që një sistem AI jashtë kontrollit mund të pushtojë dhe të zhdukë njerëzimin.

Ilya Sutskever, një themelues i OpenAI dhe ish-shkencëtar kryesor, u largua së fundmi nga kompania. Ai kishte qenë në bordin e kompanisë dhe kishte votuar për të shkarkuar Sam Altman, shefin ekzekutiv, vitin e kaluar

Kokotajlo, 31 vjeç, iu bashkua OpenAI në 2022 si studiues i AI dhe iu kërkua të parashikonte përparimin e saj. Ai nuk ishte aspak shpresëplotë.

Në punën e tij të mëparshme në një AI mbi organizimin e sigurisë, ai parashikoi se A.G.I. mund të mbërrijë në vitin 2050. Por pasi pa se sa shpejt AI ishte duke u përmirësuar, ai shkurtoi afatet kohore. Tani ai beson se ka një mundësi 50 për qind që A.G.I. do arrijë në vitin 2027, në vetëm tre vjet.

Ai gjithashtu beson se probabiliteti që çoi përpara AI do shkatërrojë ose dëmtojë në mënyrë katastrofike njerëzimin, një statistikë e zymtë.

Në OpenAI, Kokotajlo pa se edhe pse kompania kishte protokolle sigurie në fuqi, duke përfshirë një përpjekje të përbashkët me Microsoft-in e njohur si “bordi i sigurisë së vendosjes”, i cili supozohej të rishikonte modelet e reja për rreziqe të mëdha përpara se të publikoheshin, ata rrallë dukej se ngadalësonin ndonjë gjë.

Për shembull, tha ai, në vitin 2022 Microsoft filloi të provonte në heshtje në Indi një lloj të ri të motorit të tij të kërkimit Bing që disa punonjës të OpenAI besonin se përmbante një model të papublikuar në atë kohë të GPT-4, modeli më i përparuar i gjuhës së gjerë i OpenAI.

Kokotajlo tha se i ishte thënë se Microsoft nuk kishte marrë miratimin e bordit të sigurisë përpara se të provonte modelin e ri dhe pasi bordi mësoi për provat, – nëpërmjet një sërë raportesh se Bing po vepronte çuditërisht ndaj përdoruesve – nuk bëri asgjë për ta ndaluar Microsoft-in nga shtrirja e tij më gjerësisht.

Një zëdhënës i Microsoft, Frank Shaë, i kundërshtoi këto pretendime. Ai tha se provat e Indisë nuk kishin përdorur GPT-4 ose ndonjë model OpenAI. Hera e parë që Microsoft lëshoi teknologjinë e bazuar në GPT-4 ishte në fillim të vitit 2023, tha ai dhe ajo u rishikua dhe u miratua nga një paraardhës i bordit të sigurisë.

Përfundimisht, tha Kokotajlo, ai u shqetësua aq shumë sa vitin e kaluar, ai i tha Altman se kompania duhet të “orientohet drejt sigurisë” dhe të shpenzojë më shumë kohë dhe burime për t’u mbrojtur kundër rreziqeve të AI në vend që të angazhohet për të përmirësuar modelet e saj. Ai tha se Altman kishte pretenduar se ishte dakord me të, por se asgjë nuk kishte ndryshuar shumë.

Në prill, ai dha dorëheqjen. Në një email drejtuar ekipit të tij, ai tha se po largohej sepse kishte “humbur besimin se OpenAI do sillet me përgjegjësi” ndërsa sistemet e tij i afrohen inteligjencës në nivel njerëzor.

“Bota nuk është gati dhe ne nuk jemi gati”, shkroi Kokotajlo.

“Jam i shqetësuar se po nxitojmë përpara pavarësisht rreziqeve dhe po racionalizojmë veprimet tona.”

OpenAI tha javën e kaluar se kishte filluar provën e një modeli të ri AI dhe se po formonte një komitet të ri për sigurinë për të eksploruar rreziqet që lidhen me modelin e ri dhe teknologjitë e tjera të ardhshme.

Gjatë dorëheqjes, Kokotajlo kundërshtoi të firmoste dokumentet standarde të OpenAI për punonjësit që largoheshin, e cila përfshinte një klauzolë të rreptë që i ndalonte ata të thoshin gjëra negative për kompaninë, ose përndryshe rrezikon t’u hiqet kapitali i tyre.

Shumë punonjës mund të humbin miliona dollarë nëse kundërshtojnë të nënshkruajnë dokumentin. Kapitali i zotëruar i Kokotajlo ishte me vlerë rreth 1.7 milionë dollarë, tha ai, që përbënte pjesën dërrmuese të vlerës së tij neto dhe ai ishte i përgatitur të humbiste të gjitha.

Në letrën e tyre të hapur, Kokotajlo dhe ish-punonjësit e tjerë të OpenAI-t bëjnë thirrje për t’i dhënë fund përdorimit të marrëveshjeve për moszbulim në OpenAI dhe kompanitë e tjera AI.

“Marrëveshjet e gjera të konfidencialitetit na pengojnë të shprehim shqetësimet tona, me përjashtim të vetë kompanive që mund të dështojnë në adresimin e këtyre çështjeve,” shkruajnë ata.

Ata bëjnë thirrje edhe për kompanitë AI të “mbështesin një kulturë të kritikës së hapur” dhe të krijojnë një proces raportimi për punonjësit për të ngritur në mënyrë anonime shqetësimet e lidhura me sigurinë.

Ata kanë mbajtur një avokat pro bono, Lawrence Lessig, studiues dhe aktivist i shquar ligjor.

Lessig këshilloi gjithashtu Frances Haugen, një ish-punonjëse e Facebook-ut, e cila u bë një informatore dhe e akuzoi kompaninë për vendosjen e fitimeve përpara sigurisë.

Në një intervistë, Lessig tha se ndërsa mbrojtja tradicionale e sinjalizuesve zbatohej zakonisht për raportet e veprimtarisë së paligjshme, ishte e rëndësishme për punonjësit e kompanive të AI të jenë në gjendje të diskutojnë lirisht rreziqet dhe dëmet e mundshme, duke pasur parasysh rëndësinë e teknologjisë.

“Punonjësit janë një linjë e rëndësishme e mbrojtjes së sigurisë dhe nëse nuk mund të flasin lirshëm pa ndëshkim, ai kanal do mbyllet,” tha ai.

Held, zëdhënësja e OpenAI, tha se kompania kishte “rrugë të tjera për punonjësit për të shprehur shqetësimet e tyre”, duke përfshirë një linjë telefonike anonime për integritetin.

Kokotajlo dhe grupi i tij janë skeptikë se vetëm vetërregullimi do mjaftojë për t’u përgatitur për një botë me sisteme më të fuqishme AI. Kështu që ata po bëjnë thirrje që ligjvënësit të rregullojnë edhe industrinë.

“Duhet të ketë një lloj strukture qeverisëse të përgjegjshme demokratike, transparente në krye të këtij procesi,” tha Kokotajlo.

“Në vend që vetëm disa kompani të ndryshme private të garojnë me njëra-tjetrën dhe t’i mbajnë të gjitha të fshehta.”

VINI RE: Ky material është pronësi intelektuale e NY Times

Përgatiti për Hashtag.al, Klodian Manjani